如何在STM32上运行AI应用

2024-09-29

2217

来源:米尔电子

1.X-Linux-AI概述

X-LINUX-AI 是 STM32 MPU OpenSTLinux 扩展包,面向 STM32MP1 和 STM32MP2 系列微处理器的人工智能。它包含 Linux® AI 框架,以及用于开始一些基本使用案例的应用程序示例。

X-LINUX-AI 中提供的示例包括一系列用于图像分类、对象检测、语义分割和人体姿势估计的优化模型。X-LINUX-AI 中作为预构建二进制文件提供的人脸识别应用程序基于 STMicroelectronics 重新训练的模型。

这些示例依赖于基于 TensorFlow™ Lite 推理引擎、ONNX 运行时、OpenVX™ 或 Google Edge TPU™ 加速器的 STAI_MPU API。它们都支持 Python™ 脚本和 C/C++ 应用程序。本文内容将通过MYD-LD25X来演示这些示例demo。

1.1. 硬件资源

带有烧录好MYiR发布镜像的MYD-LD25X开发板

MY-LVDS070C屏幕或者任意HDMI接口显示器

MY-CAM003M米尔MIPI-CSI摄像头模块

1.2.软件资源

本文内容操作均在MYD-LD25X开发板的调试串口执行,请确保先完成了MYD-LD25X快速使用指南(也就是开发板附带的小册子)上的基本内容,并且需要确保开发板能够联通互联网,提供网络的方式有多种,可以是能够连接互联网的路由器,也可以是Wifi,Wifi具体的连接方式可以查阅发布资料中《MYD-LD25X Linux 软件评估指南》Wifi的STA连接章节。

2.开发板安装X-Linux-AI

本章主要介绍如何在MYD-LD25X开发板上安装X-Linux-AI以及相关demo组件等。

2.1.配置准备环境

1)获取校准参数

如果在MYD-LD25X使用LVDS屏幕,初次使用进入weston需要校准屏幕,校准的自动化脚本操作默认添加在autorun脚本中,如果已经执行过校准操作或者使用HDMI屏幕,则可以跳过该小节内容。

运行autorun.sh脚本执行校准操作:

# autorun.sh

执行后lvds屏幕会出现触摸点位,以此点击后完成校准,之后使用屏幕无需再次校准。

2)关闭HMI

避免出现显示冲突,在MYD-LD25X登录后,执行以下操作关闭mxapp2程序也就是MYiR的HMI界面:

# killall mxapp2

并且将autorun脚本中启动mxapp2的行注释掉,下次启动后就不会自动运行了:

# vi /usr/bin/autorun.sh #!/bin/sh ...省略 sync #/usr/sbin/mxapp2 &

3)更新软件源

执行以下命令更新软件源:

# apt update The software package is provided AS IS, and by downloading it, you agree to be bound to the terms of the software license agreement (SLA). The detailed content licenses can be found at https://wiki.st.com/stm32mpu/wiki/OpenSTLinux_licenses. Get:1 http://packages.openstlinux.st.com/5.1 mickledore InRelease [5,723 B] Get:2 http://packages.openstlinux.st.com/5.1 mickledore/main arm64 Packages [725 kB] Get:3 http://packages.openstlinux.st.com/5.1 mickledore/updates arm64 Packages [38.2 kB] Get:4 http://packages.openstlinux.st.com/5.1 mickledore/untested arm64 Packages [1,338 kB] Fetched 2,107 kB in 3s (690 kB/s) Reading package lists... Done Building dependency tree... Done 1 package can be upgraded. Run 'apt list --upgradable' to see it.

更新源需要MYD-LD25X连接互联网,请确保网络通畅。执行上述命令时,可能会出现以下问题导致更新错误:

l同步时间问题

E: Release file for http://packages.openstlinux.st.com/5.1/dists/mickledore/InRelease is not valid yet (invalid for another 1383d 8h 14min 14s). Updates for this repository will not be applied. E: Release file for http://extra.packages.openstlinux.st.com/AI/5.1/dists/mickledore/InRelease is not valid yet (invalid for another 1381d 8h 10min 47s). Updates for this repository will not be applied.

出现上述问题的原因是当前开发板时间没有和网络时间成功同步,执行以下操作同步网络时间,首先修改timesyncd.conf配置文件,新增FallbackNTP授时中心网站,按如下所示修改:

# vi /etc/systemd/timesyncd.conf ... [Time] #NTP= FallbackNTP=ntp.ntsc.ac.cn cn.ntp.org.cn ...

然后输入如下命令重启同步时间服务:

# systemctl restart systemd-timesyncd

再次输入date查看时间是否成功更新,根据网络情况不同部分情况可能需要一定时间同步:

# date 2023年 03月 03日 星期五 17:50:37 CST # date 2024年 09月 20日 星期五 15:45:15 CST

lDNS问题

运行apt update后可能会出现以下问题:

# apt update ... Err:1 http://packages.openstlinux.st.com/5.1 mickledore InRelease Temporary failure resolving 'packages.openstlinux.st.com' Reading package lists... Done Building dependency tree... Done All packages are up to date. W: Failed to fetch http://packages.openstlinux.st.com/5.1/dists/mickledore/InRelease Temporary failure resolving 'packages.openstlinux.st.com' W: Some index files failed to download. They have been ignored, or old ones used instead.

该问题需要修改/etc/resolve.conf,在文件中添加如下内容:

# vi /etc/resolv.conf ... nameserver 8.8.8.8 nameserver 8.8.4.4

2.2.安装x-linux-ai-tool

当完成环境配置后,输入以下命令安装x-linux-ai-tool:

# apt-get install -y x-linux-ai-tool

安装完成后,输入以下命令确认是否安装完成:

# x-linux-ai -v X-LINUX-AI version: v5.1.0

关于x-linux-ai工具的使用,可以通过x-linux-ai -h查看或者浏览官方wiki:

2.3.安装 X-LINUX-AI 演示包

要开始使用 X-linux-ai,需要安装 X-linux-ai 演示包,该包提供了针对所用特定目标优化的所有 Ai 框架、应用程序示例、工具和实用程序:

# x-linux-ai -i packagegroup-x-linux-ai-demo

2.4.运行demo启动器

ST的官方demo启动器在MYD-LD25X默认已经移除,为了方便使用X-linu-ai的demo应用,需要重新添加随weston自启动的官方demo展示程序。

进入/usr/local/weston-start-at-startup目录,并新建start_up_demo_launcher.sh脚本,按照如下操作添加对应内容到脚本中:

# cd /usr/local/weston-start-at-startup # vi start_up_demo_launcher.sh #!/bin/sh DEFAULT_DEMO_APPLICATION_GTK=/usr/local/demo/launch-demo-gtk.sh if [ -e /etc/default/demo-launcher ]; then source /etc/default/demo-launcher if [ ! -z "$DEFAULT_DEMO_APPLICATION" ]; then $DEFAULT_DEMO_APPLICATION else $DEFAULT_DEMO_APPLICATION_GTK fi else $DEFAULT_DEMO_APPLICATION_GTK fi

然后添加运行权限给脚本:

# chmod a+x start_up_demo_launcher.sh

最后重启weston服务后,可以看到启动器成功运行:

# systemctl restart weston-graphical-session.service

图2-1. demo启动器-1

图2-2. demo启动器-2

3.运行AI 应用实例

本章节将简单展示上文安装后的几个Demo具体情况,在执行Demo前,需要准备好1.1小节的硬件资源。

以下demo运行都需要使用到MIPI-CSI摄像头,适用于MYD-LD25X开发板的摄像头型号为米尔的MY-CAM003M,在使用该摄像头前需要按照以下命令来初始化配置并事先预览确保摄像头能够正常工作。

进入/etc/myir_test目录,运行myir_camera_play脚本:

# cd /etc/myir_test # ./myir_camera_play

执行后,屏幕上会出现摄像头预览画面,请确保画面显示正常,如果存在问题,请查阅《MYD-LD25X Linux 软件评估指南》中关于MIPI-CSI摄像头的部分检查摄像头连接情况等来排查问题,如有需要请咨询米尔技术支持。

3.1.图像分类

图像分类神经网络模型可以识别图像所代表的对象。它将图像分类为不同的类别。该应用展示了一个计算机视觉的图像分类用例,从相机输入(/dev/videox)捕获帧,并通过OpenVX、TFLite或ONNX框架解析的神经网络模型进行分析。

3.1.1.通过demo启动器运行

可以通过点击demo启动器中的Image Classifiction样例图标来运行该demo,默认情况下,通过2.3小节安装的是OpenVX的应用程序,并且由C/C++和Python两种。

图3-1. 图像分类

3.1.2.通过命令运行

图像分类的C/C++和Python应用程序位于/usr/local/x-linux-ai/image-classification/目录中,可以通过运行程序加-h参数来获取更多帮助信息:

# cd /usr/local/x-linux-ai/image-classification/ # ls -la stai_mpu_image_classification #C++运行程序 stai_mpu_image_classification.py #Python运行程序

为了简化demo的启动,在应用程序目录下有配置好的启动脚本:

使用相机输入启动图像分类demo

launch_bin_image_classification.sh #C++运行程序 launch_python_image_classification.sh #Python运行程序

使用图片输入启动图像分类demo

launch_bin_image_classification_testdata.sh #C++运行程序 launch_python_image_classification_testdata.sh #Python运行程序

3.1.3.demo展示

通过demo启动器启动默认为使用相机输入,和命令启动中使用相机输入的脚本运行结果一致,这里以C/C++程序为例,具体测试情况如下:

# cd /usr/local/x-linux-ai/image-classification # ./launch_bin_image_classification.sh #或者点击demo启动器图标

图3-2. 摄像机输入

运行图片输入的程序脚本前,需要准备识别的图片,这里以一张泰迪熊的图片为例,图片放置目录为/usr/local/x-linux-ai/image-classification/models/mobilenet/testdata,然后运行脚本,这里以C/C++应用程序为例。

# cd /usr/local/x-linux-ai/image-classification/models/mobilenet/testdata # ls -la -rwxr--r-- 1 root root 102821 9 20 23:14 teddy.jpg # cd /usr/local/x-linux-ai/image-classification # ./launch_bin_image_classification_testdata.sh

运行结果如下:

图3-3. 图片输入

3.2.对象检测

该应用展示了一个计算机视觉的对象检测用例,从相机输入(/dev/videox)捕获帧,并通过OpenVX、TFLite或ONNX框架解析的神经网络模型进行分析。使用Gstreamer管道来流式传输相机帧(使用v4l2src),显示预览(使用gtkwaylandsink),并执行神经网络推理(使用appsink)。

3.2.1.通过demo启动器运行

可以通过点击demo启动器中的Object Detection样例图标来运行该demo,默认情况下,通过2.3小节安装的是OpenVX的应用程序,并且由C/C++和Python两种。

图3-4. 对象检测

3.2.2.通过命令运行

对象检测的C/C++和Python应用程序位于/usr/local/x-linux-ai/object-detection/目录中,可以通过运行程序加-h参数来获取更多帮助信息:

# cd /usr/local/x-linux-ai/object-detection/ # ls -la stai_mpu_object_detection #C++运行程序 stai_mpu_object_detection.py #Python运行程序

为了简化demo的启动,在应用程序目录下有配置好的启动脚本:

使用相机输入启动对象检测demo

launch_bin_object_detection.sh #C++运行程序 launch_python_object_detection.sh #Python运行程序

使用图片输入启动对象检测demo

launch_bin_object_detection_testdata.sh #C++运行程序 launch_python_object_detection_testdata.sh #Python运行程序

3.2.3.demo展示

通过demo启动器启动默认为使用相机输入,和命令启动中使用相机输入的脚本运行结果一致,这里以C/C++程序为例,具体测试情况如下:

# cd /usr/local/x-linux-ai/object-detection # ./launch_bin_object_detection.sh #或者点击demo启动器图标

图3-5. 摄像机输入

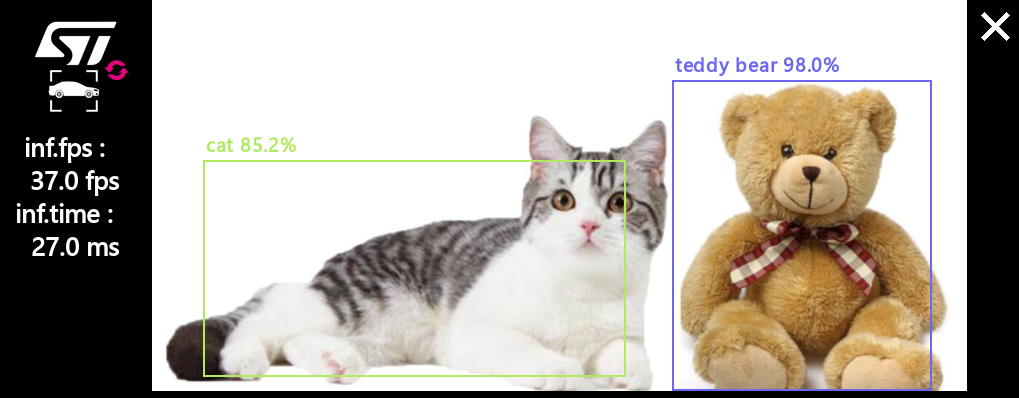

运行图片输入的程序脚本前,需要准备识别的图片,这里以一张泰迪熊和小猫的图片为例,图片放置目录为:

/usr/local/x-linux-ai/object-detection/models/coco_ssd_mobilenet/testdata

然后运行脚本,这里以C/C++应用程序为例。

# cd /usr/local/x-linux-ai/object-detection/models/coco_ssd_mobilenet/testdata # ls -la -rwxr--r-- 1 root root 102821 9 20 23:14 teddy-and-cat.jpg # cd /usr/local/x-linux-ai/object-detection # ./launch_bin_object_detection_testdata.sh

运行结果如下:

图3-6. 图片输入

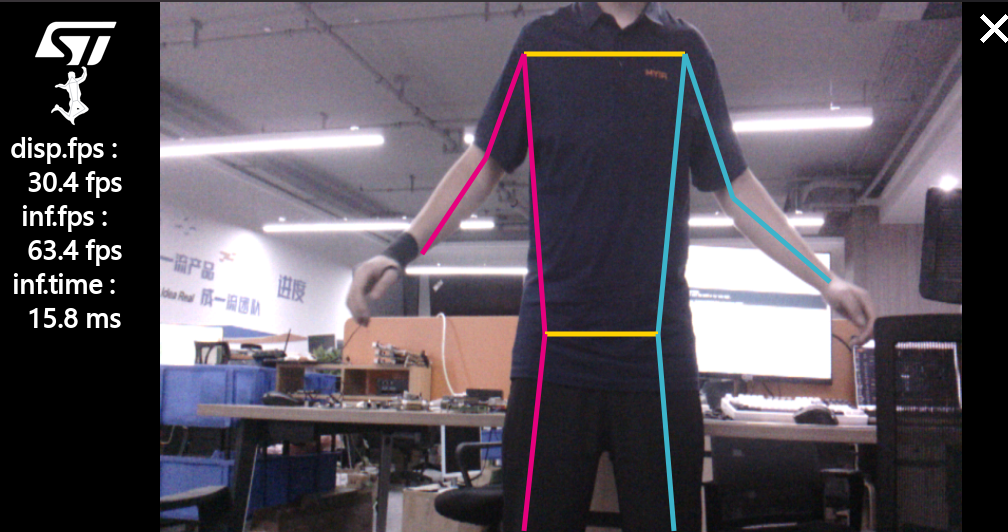

3.3.姿势估计

该应用展示了一个计算机视觉的人体姿态估计用例,从相机输入(/dev/videox)捕获帧,并通过OpenVX框架解析的神经网络模型进行分析。该应用使用的模型是从stm32-hotspot ultralytics的GitHub分支下载的ST YoloV8n-pose。

3.3.1.通过demo启动器运行

可以通过点击demo启动器中的Pose Estimation样例图标来运行该demo,默认情况下,通过2.3小节安装的是OpenVX的应用程序,默认为Python应用程序。

图3-7. 姿势估计

3.3.2.通过命令运行

姿势估计的C/C++和Python应用程序位于/usr/local/x-linux-ai/object-detection/目录中,可以通过运行程序加-h参数来获取更多帮助信息:

# cd /usr/local/x-linux-ai/pose-estimation/ # ls -la stai_mpu_pose_estimation.py

为了简化demo的启动,在应用程序目录下有配置好的启动脚本:

使用相机输入启动姿势估计demo

launch_python_pose_estimation.sh

使用图片输入启动姿势估计demo

launch_python_pose_estimation_testdata.sh

3.3.3.demo展示

通过demo启动器启动默认为使用相机输入,和命令启动中使用相机输入的脚本运行结果一致,这里以C/C++程序为例,具体测试情况如下:

# cd /usr/local/x-linux-ai/pose-estimation/ # ./launch_python_pose_estimation.sh #或者点击demo启动器图标

图3-8. 摄像机输入

运行图片输入的程序脚本前,需要准备识别的图片,这里以一张人跑步的图片为例,图片放置目录为:/usr/local/x-linux-ai/pose-estimation/models/yolov8n_pose/testdata,然后运行脚本,这里以C/C++应用程序为例。

# cd /usr/local/x-linux-ai/pose-estimation/models/yolov8n_pose/testdata # ls -la -rwxr--r-- 1 root root 102821 9 20 23:14 person-run.jpg # cd /usr/local/x-linux-ai/pose-estimation # ./launch_python_pose_estimation_testdata.sh

运行结果如下:

图3-9. 图片输入

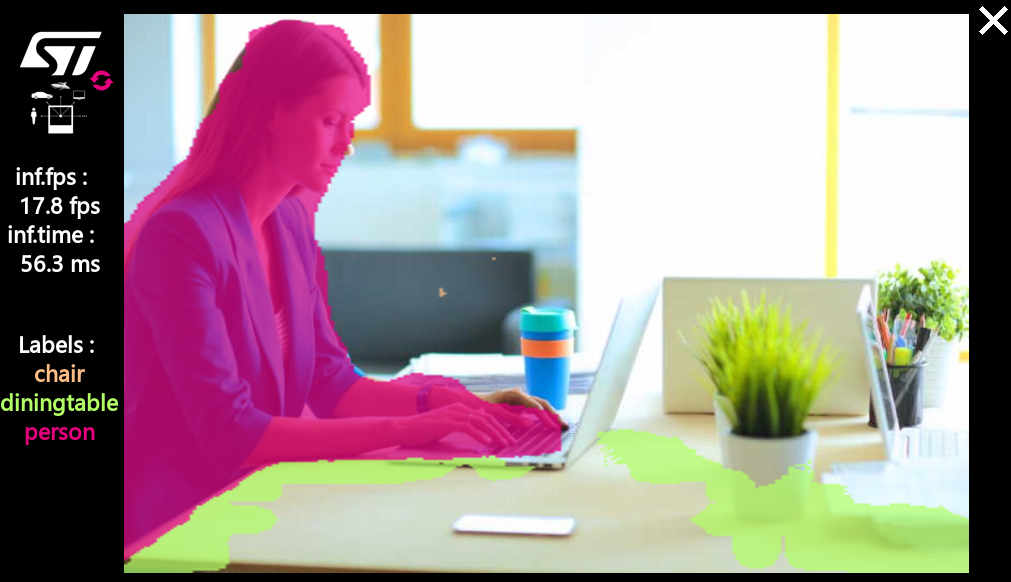

3.4.语义分割

该应用展示了一个计算机视觉的语义分割用例,从相机输入(/dev/videox)捕获帧,并通过OpenVX框架解析的神经网络模型进行分析。使用Gstreamer管道来流式传输相机帧(使用v4l2src),显示预览(使用gtkwaylandsink),并执行神经网络推理(使用appsink)。推理结果显示在预览中,叠加是使用GtkWidget和cairo实现的。该应用使用的模型是从TensorFlow™ Lite Hub下载的DeepLabV3。

3.4.1.通过demo启动器运行

可以通过点击demo启动器中的Semantic Segmentation样例图标来运行该demo,默认情况下,通过2.3小节安装的是OpenVX的应用程序,默认为Python应用程序。

图3-10. 语义分割

3.4.2.通过命令运行

语义分割的C/C++和Python应用程序位于/usr/local/x-linux-ai/object-detection/目录中,可以通过运行程序加-h参数来获取更多帮助信息:

# cd /usr/local/x-linux-ai/semantic-segmentation/ # ls -la stai_mpu_semantic_segmentation.py

为了简化demo的启动,在应用程序目录下有配置好的启动脚本:

使用相机输入启动语义分割demo

launch_python_semantic_segmentation.sh

使用图片输入启动语义分割demo

launch_python_semantic_segmentation_testdata.sh

3.4.3.demo展示

通过demo启动器启动默认为使用相机输入,和命令启动中使用相机输入的脚本运行结果一致,这里以C/C++程序为例,具体测试情况如下:

# cd /usr/local/x-linux-ai/semantic-segmentation/ # ./launch_python_semantic_segmentation.sh #或者点击demo启动器图标

图3-11. 摄像机输入

运行图片输入的程序脚本前,需要准备识别的图片,这里以一张人正在办公的图片为例,图片放置目录为:

/usr/local/x-linux-ai/semantic-segmentation/models/deeplabv3/testdata

然后运行脚本,这里以C/C++应用程序为例。

# cd /usr/local/x-linux-ai/semantic-segmentation/models/deeplabv3/testdata # ls -la -rwxr--r-- 1 root root 102821 9 20 23:14 person-work.jpg # cd /usr/local/x-linux-ai/semantic-segmentation # ./launch_python_semantic_segmentation_testdata.sh

运行结果如下:

图3-12. 图片输入

4. 参考资料

lX-Linux-AI-Tool

lST 官方Wiki

2026-02-11

【干货】米尔T153开发板AD7616高速ADC采集系统详解

PART 01项目概述1.1 技术背景米尔MYD-YT153开发板搭载全志T153处理器,提供LocalBus(LBC)并行总线接口,适合连接高速外设。AD7616是ADI公司推出的16位高精度并行ADC,具有16通道差分输入,广泛应用于工业数据采集、仪器仪表等领域。1.2 项目目标验证MYD-YT153 LocalBus与AD7616的硬件兼容性提供完整的软件驱动实现方案评估系统在实际应用中的性

2026-01-29

新法规欧标AC桩一站式技术实现方案

面对欧盟Delegated Regulation (EU) 2025/656条例设定的明确技术路线与2027年强制生效节点,开发符合 EN ISO 15118-20:2022 标准的下一代智能交流充电桩,已成为产品进入欧洲市场的唯一路径。这意味着,传统PWM通信方式即将淘汰,全面转向基于 GreenPHY电力线载波(PLC)的高层通信,并强制集成即插即充(PnC)与车辆到电网(V2G)能力。01硬

2026-01-22

看过来,米尔RK3576 NPU方案你用对了吗?

本文基于米尔MYD-LR3576开发板,详细记录了如何利用500万像素USB摄像头实现640×640分辨率的YOLO5s目标检测,并将结果实时输出至1080P屏幕的全流程。通过系统级的软硬件协同优化,最终将端到端延迟控制在40ms以内,实现了 20FPS的稳定实时检测性能。文章重点剖析了摄像头特性分析、显示通路选择、RGA硬件加速、RKNN NPU集成等关键技术环节,为嵌入式AI视觉系统的开发与调

2026-01-22

全场景工控与网关解决方案:从入门到旗舰的一站式选型

在工业自动化与物联网向深度智能迈进的浪潮中,工业设备对成本控制、运行可靠性及智能算力的要求正持续攀升。无论是追求极致性价比的基础工控终端,还是需要强劲算力支撑的AIoT边缘节点,开发者都在为不同场景寻觅适配的“工业之芯”。对此,我们基于MYC-YR3506、MYC-LT536、MYC-LR3576三款核心板,打造了覆盖低、中、高端全场景的工业控制与网关解决方案,以一站式选型体系,助力工业产品实现“

2026-01-15

当国产芯遇上机器人:RK3576的ROS2奇幻之旅

当RK3576的强劲“大脑”(四核A72+四核A53)与强大的GPU、VPU、NPU加速模块相遇,一场高性价比的机器人开发革命正在悄然发生。我们成功将完整的Ubuntu 22.04与ROS2 Humble生态系统,完美移植到了这颗国产芯片上。一个稳定、全功能的机器人软件开发平台已经就绪,现在就来一起探索它的强大魅力!一、系统启动与基础性能展示1.硬件平台简介开发板:MYD-LR3576存储:eMM

2026-01-15

内置全栈安全,一站式满足CRA法案与IEC 62443标准-米尔MYC-LF25X核心板

面对日益严峻的网络安全挑战,欧盟《网络弹性法案》(CRA)的出台与工业安全标准IEC 62443的广泛应用,为设备制造商筑起了新的合规门槛。安全不再是可选功能,而是产品设计的强制基石。米尔电子推出的MYC-LF25X嵌入式处理器模组,基于已通过SESIP 3级认证的意法半导体STM32MP257F处理器,提供从硬件信任根到应用层的全栈、可验证安全架构,是您高效开发符合国际法规与标准的安全关键型应用

2025-12-26

补贴太香了!158元买米尔NXP i.MX 91开发板,限购300套

太香了!限时补贴狂欢,回馈您的支持!米尔基于NXP i.MX 91开发板仅158元,限量300套,先到先得。该开发板基于新一代NXP i.MX 91系列处理器设计,搭载Arm Cortex-A55核心,集成双千兆以太网和双 USB 端口等丰富外设,支持Linux、Android等主流操作系统,赋能新一代入门级Linux应用,适用于工业控制、智能终端、物联网等领域的原型开发与教学实践。产品型号:MY

2025-12-19

Buildroot MQTT-Modbus 网关开发,实现设备远程监控方案-米尔RK3506

在工业物联网与智能家居场景中,远程设备监控的核心痛点是工业总线协议与物联网协议的兼容性问题。基于RK3506 Buildroot系统开发的MQTT-Modbus网关产品,通过协议桥接技术完美解决这一难题,为低成本、高可靠的远程监控提供了高效解决方案。一、核心开发平台与技术选型硬件平台选用RK3506处理器作为网关核心硬件,该芯片具备低功耗、高性价比特性,支持多接口扩展,完全适配工业级嵌入式场景需求

2025-12-19

SDK重磅升级,RK3506核心板解锁三核A7实时控制新架构

在工业控制与边缘智能领域,开发者的核心需求始终明确:在可控的成本内,实现可靠的实时响应、稳定的通信与高效的开发部署。米尔电子基于RK3506处理器打造的MYC-YR3506核心板平台,近期完成了一次以“实时性”和“可用性”为核心的SDK战略升级,致力于将多核架构的潜力转化为工程师可快速落地的产品力。本次升级围绕两大主线展开:系统生态的多样化与实时能力的深度释放。我们不仅提供了从轻量到丰富的操作系统

2025-12-11

赋能欧标充电桩市场:OCPP协议实战开发指南

随着全球电动汽车产业的迅猛发展,充电基础设施的智能化与标准化已成为行业迫切需求。OCPP(Open Charge Point Protocol即开放充电点协议)作为连接充电桩与中央管理系统的"通用语言",正成为解决设备互联互通难题的关键技术。一、OCPP:为何是出海欧标的必选项?OCPP是一个开放、标准的通信协议,它确保了不同制造商生产的充电桩能够与任何兼容的后台管理系统进行无